Pomysł wziął się z auto-obserwacji często powtarzającego się schematu. Leci to mniej więcej tak:

Oglądam lub czytam jakiś film czy tekst w temacie AI i automatyzacji.

Zatrzymuję się myśląc: “Co to u licha znaczy?”

Wyszukuję dany skrót / termin w Googlu.

Przelatuję na szybko przez kilka artykułów.

Wracam do swojego filmu. Niby rozumiem, ale jednak nie do końca.

Oglądam całość filmu ale połowa wiedzy już zdążyła wylecieć drugim uchem.

Wkurzam się, że to całe AI to nie dla mnie! Ja wolę czytać poezje i rzucać wróblom wyschniętą kajzerkę w parku! Durna, durna, durna!… ta sztuczna inteligencja.

Nie tędy droga. Nie ma co się mazać.

Niestety, algorytmy Google działają, jak działają. Pierwsze wyniki po wpisaniu frazy “Co to [X]?” to, przeważnie, artykuły pod SEO. Muchłopaki na szczycie lejków sprzedażowych.

(Dlatego Google tak mocno dostaje po tyłku od modeli AI, które potrafią przeszukiwać sieć)

Ale dzisiaj nie o tym. Dzisiaj zebrałem dla Ciebie 5 najgorętszych, zarówno technicznych, jak i slangowych terminów ze świata sztucznej inteligencji.

I wytłumaczyłem je, bo jakżeby inaczej, na chłopski rozum. B-)

Agent AI vs Automatyzacja

Zaczynamy od czegoś hiper-ważnego. Od rozróżnienia faktycznego Agenta AI od automatyzacji, która, po prostu, używa sztucznej inteligencji.

Uwaga test:

Czy sekwencja, która:

Pobiera z internetu Tweety wszystkich polskich polityków,

Wkleja je do ChataGPT, który podsumowuje je w jeden artykuł,

Znajduje osoby na liście mailowej, które ostatnio otworzyły maila w podobnym temacie,

Wysyła je do nich.

Jest Agentem AI?

Odpowiedź brzmi: nie.

Czemu?

Bo definicja Agenta jest prosta:

Agent AI to program, który działa samodzielnie, podejmuje decyzje i wykonuje zadania na podstawie danych oraz określonych celów

Samodzielność to coś, co tworzy Agenta. W powyższej automatyzacji mamy, de facto, szereg predefiniowanych zachowań. Brak tam miejsca na autonomiczne podejmowanie decyzji przez maszynę.

Więc już wiecie. Nie dacie sobie wcisnąć kitu.

Żeby nie było, że wyssałem to z palca, tutaj artykuł od Anthropic, w którym mowa o powyższym rozrużnieniu.

MCP - Model Context Protocol

MCP to krok milowy w kierunku prawdziwych Agentów AI.

Jest to, opracowany przez Anthropic, uniwersalny protokół, który skrajnie ułatwia modelom LLM łączenie się z zewnętrznymi aplikacjami.

Prościej: to coś jak kabel USB-C dla agentów, który pasuje wszędzie.

Na przykładzie:

Do tej pory, żeby agent połączył się z zewnętrznymi aplikacjami, takimi jak np. skrzynka pocztowa Gmail, potrzebował oddzielnego modułu, żeby:

odebrać wiadomość

edytować wiadomość

oznaczyć wiadomość

usunąć wiadomość

wysłać wiadomość… itd.

A przy wykorzystaniu kilku, dodatkowych aplikacji (Kalendarz, Whatsapp, MailerLite) złożoność całości rosła wykładniczo.

Link do oryginalnego [LINK].

Vibe coding

Podobno termin został pierwszy raz użyty przez naszego ukochanego YTbera z poprzedniego wydania - Andrej’a Karpathy’ego.

Vibe coding to, po prostu, kodowanie polegające na korzystaniu wyłącznie z ‘ludzkiego języka’.

Termin zyskał na popularności po wypuszczeniu, przez Anthropic (znowu ten Anthropic), modelu Claude 3.7 Sonnet, który bije na głowę konkurencję w jakości i łatwości kodowania.

Aplikacje, jak Lovable, Bolt.new, czy Cursor wykorzystały ów model, dodały elegancki interfejs i voilà… Tysiące vibe coderów, w fali ekscytacji, rzuciło się i zaczęło tworzyć naprawdę ciekawe projekty.

Co więcej, Y Combinator (akcelerator start-upów, który stoi za sukcesem m.in: Airbnb, Coinbase, Dropbox, Instacart, Reddit, Stripe i Twitch) nagrał 30-minutową rozmowę zatytułowaną: “Vibe Coding Is The Future” [LINK].

Benchmarki

Jako ludzie uwielbiamy regulować i statstycznie uśredniać złożone (i wielowątkowe) tematy, aby były łatwiejsze do objęcia rozumem.

Dla świata sztucznej inteligencji takim czymś są benchmarki.

Określają, jak modele radzą sobie z jakością odpowiedzi, szybkością działania, umiejętnościami analitycznymi itp. itd.

Nie jestem zwolennkiem takiego podejścia, bo nie uwzględnia życiowych, codziennych zastosowań przeciętnego użytkownika.

Niemniej jednak, warto wiedzieć, który model w danym momencie bryluje na szczycie tablicy wyników.

Samemu sprawdzam (i polecam) Chatbot Arena LLM Leaderboard [LINK]

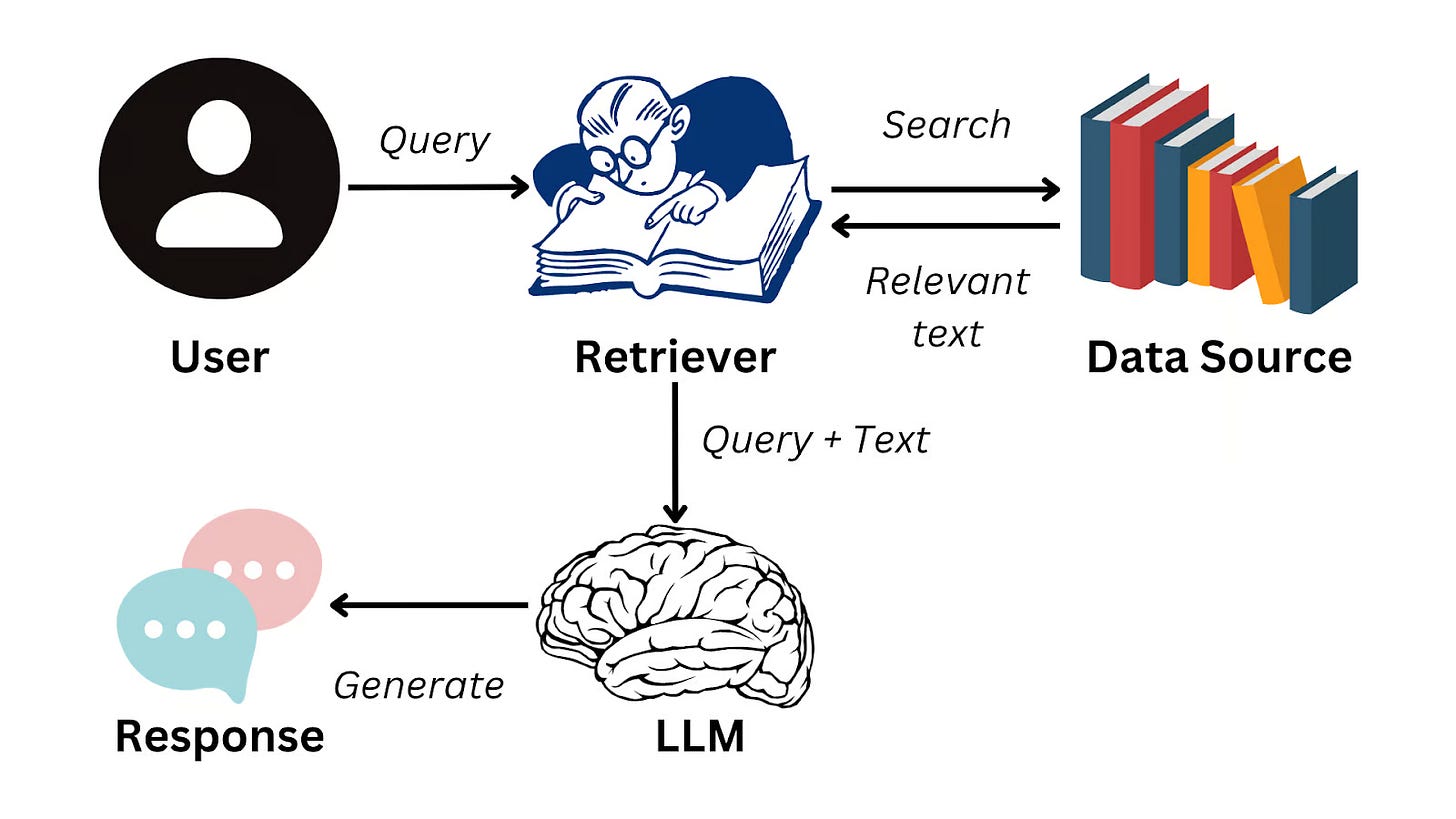

RAG - Retrieval-Augmented Generation

Na koniec coś bardziej technicznego.

LLMy (jak ChatGPT, Claude, DeepSeek), jak wiecie lub nie, fundamentalnie są zamkniętym folderem ZIP przeszkolonym na miliardach danych z internetu… ALE:

a) tylko do określonej daty,

b) tylko (miejmy nadzieję) na szeroko dostępnych treściach.

Dlatego, jeśli zapytasz się na jaką kwotę opiewała Twoja ostatnia faktura dla podwykonawcy Zbigniewa za budowę domku modułowego, nie dostaniesz zadowalającej odpowiedzi.

Ale z odpowiednio zaimplementowanym RAG, byłoby to już możliwe.

Bo RAG to nic innego, jak ściągawka dla modelu AI. Zanim odpowie, patrzy w notatki wypełnione dodatkowym, prywatnym kontekstem (dokumenty, dane, procesy), żeby zwrócić faktycznie przydatną odpowiedź.

To by było na tyle. Daj znać, jeśli masz jeszcze jakiś temat ze świata AI, którego nie sposób zrozumieć.

Mam dla Was jeszcze małą ciekawostkę. Poniżej, możecie dołączyć do naszego wewnętrznego Chatu na Substacku, gdzie będę dzielił się szybkimi strzałami, newsami i narzędziami, które nie zawsze się załapują do cotygodniowego wydania.

Dzięki za dziś!

Dobrego dnia,

Mikołaj Abramczuk